Analyses et outils issus de nos expériences pour structurer une collaboration Humain–IA responsable.

Gouvernance IA - PME & institutions : Le minimum viable Décider sans déléguer la responsabilité à l’algorithme

Dans de nombreuses organisations, l’intelligence artificielle ne fait pas l’objet d’une décision stratégique formelle. Elle s’installe progressivement, au fil des outils utilisés par les collaborateurs, des enseignants ou des équipes métiers. Cette adoption "par le bas" crée un paradoxe : l’IA est déjà là, mais sans cadre explicite de responsabilité. Cela s'appelle un phénomène de Shadow AI (Traduction : IA de l’ombre ou IA fantôme).

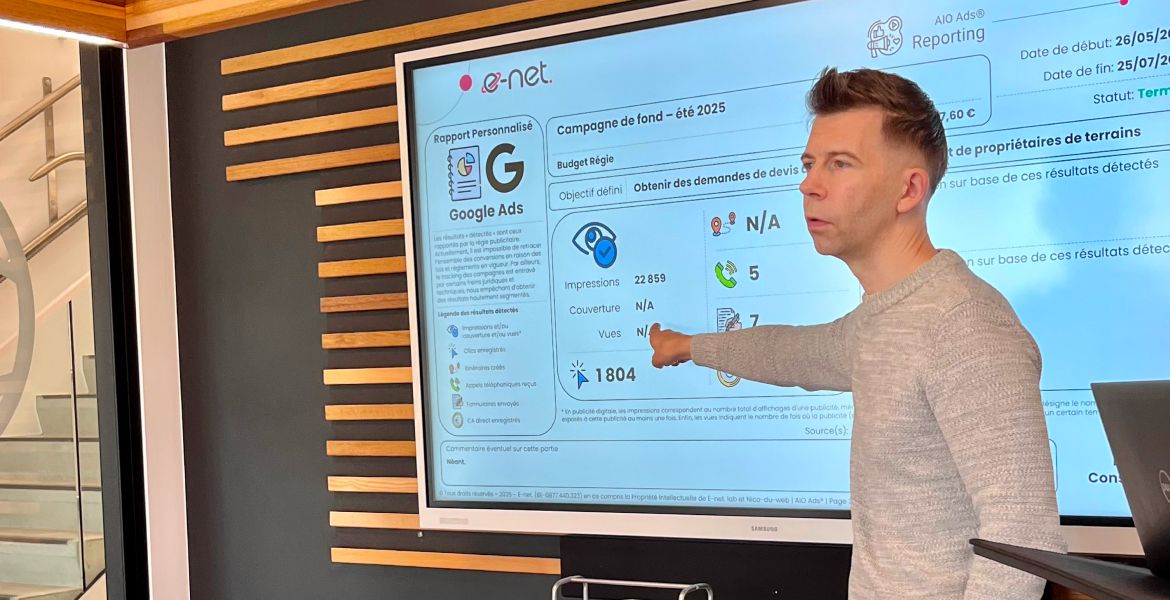

À travers ses travaux de recherche-action, le e-net. lab observe que le principal risque n’est pas l’absence de gouvernance sophistiquée, mais l’absence de gouvernance tout court.

Cet article propose un modèle de gouvernance IA minimal viable, pensé pour les PME et les institutions : simple, digeste, applicable immédiatement, sans créer d’usine à gaz.

Le problème observé : quand l’IA arrive "par le bas"

Dans la majorité des structures observées par le e-net. lab, l’IA n’est pas introduite par une décision de direction, mais par des usages individuels : outils de rédaction, d’analyse, de traduction, de préparation de décisions ou de contenus.

Ce déploiement diffus crée une situation ambiguë : tout le monde utilise l’IA, mais personne n’en est réellement responsable. Les règles sont implicites, les limites floues, et les risques mal identifiés.

Cette absence de cadre n’est pas le fruit d’un refus, mais d’un décalage : la gouvernance est perçue comme complexe, juridique ou réservée aux grandes organisations.

Résultat : on agit d’abord, on cadre plus tard, parfois trop tard.

Pourquoi une gouvernance IA minimale devient indispensable ?

La gouvernance n’est pas une réponse à la technologie, mais à la responsabilité. Lorsqu’une organisation utilise l’IA, elle engage sa responsabilité juridique, sa crédibilité et la confiance de ses collaborateurs, usagers ou citoyens.

Sans gouvernance minimale, plusieurs risques apparaissent : dilution de la responsabilité ("c’est l’outil qui a proposé") ; usage de données sensibles sans cadre ; décisions automatisées sans validation humaine et incapacité à expliquer ou corriger une erreur.

La question n’est donc pas faut-il gouverner l’IA ? Mais comment le faire sans bloquer l’action ?

Le modèle e-net. lab : une gouvernance IA "minimum viable"

Le e-net. lab propose un modèle volontairement sobre, fondé sur une conviction simple : une gouvernance imparfaite mais appliquée vaut mieux qu’un cadre idéal jamais mis en œuvre. Ce modèle de gouvernance IA "minimum viable" fait partie du cadre de pilotage humain et stratégique à l’ère de l’intelligence artificielle nommé e-net.® H-IA Pilot. Il repose sur trois piliers :

-

Une page de règles claires (code de conduite IA interne)

-

Trois registres simples pour rendre les usages visibles

-

Des rôles identifiés, sans multiplier les comités

Le code de conduite IA interne : 1 page, pas plus

La première brique de la gouvernance minimale est un code de conduite IA interne, limité à une page.

Son objectif n’est pas de tout prévoir, mais de poser des règles compréhensibles par tous, applicables immédiatement.

Exemples de 10 règles structurantes

-

Tout usage d’IA doit être transparent vis-à-vis de l’organisation.

-

Aucune décision à impact ne peut être prise sans validation humaine.

-

L’IA ne remplace pas le jugement, elle l’assiste.

-

Certaines décisions ou publics peuvent être explicitement interdits à l’IA.

-

Les données sensibles font l’objet d’une vigilance renforcée.

-

Les sources et limites doivent être connues avant diffusion.

-

Les usages doivent pouvoir être expliqués et contestés.

-

Les erreurs ou incidents doivent être signalés, sans sanction automatique.

-

La formation minimale est un prérequis à l’usage professionnel.

-

Le cadre est évolutif et révisable collectivement.

Ces règles ne sont pas juridiques : elles sont opérationnelles et pédagogiques.

Les 3 registres : piloter sans surveiller

La seconde brique repose sur trois registres simples. Leur objectif n’est pas le contrôle, mais la visibilité collective.

1. Registre des cas d’usage

Il recense qui utilise l’IA, pour quoi, avec quel niveau de risque. Ce registre permet de répondre à une question clé : où l’IA est-elle réellement utilisée dans l’organisation ?

2. Registre des données

Il documente les types de données utilisées, leur provenance, leur sensibilité, leur mode de conservation. Ce registre est essentiel pour éviter l’usage involontaire de données sensibles ou non conformes.

3. Registre des incidents

Il recense les erreurs manifestes, les hallucinations, les fuites de données, et les litiges ou contestations. L’objectif n’est pas de sanctionner, mais d’apprendre collectivement à partir des incidents.

Les rôles clés : peu nombreux, clairement identifiés

Une gouvernance minimale ne nécessite pas de comité complexe. Quatre rôles suffisent dans la plupart des organisations :

-

Responsable de la cohérence stratégique : assume la responsabilité globale de l’utilisation de l’IA.

-

Référent du cadre : coordonne les usages et les registres.

-

Référent légal / conformité : apporte un regard juridique ponctuel.

-

Utilisateurs : utilisateurs responsables et contributeurs du cadre.

L’important n’est pas le titre, mais la clarté des responsabilités.

Ce que cette gouvernance n’est pas et pourquoi l’éducation est centrale ?

Il est essentiel de lever un malentendu fréquent : une gouvernance IA minimale n’est ni un dispositif de contrôle, ni une contrainte descendante. Cela s’appelle un top-down. Elle ne repose ni sur l’interdiction déguisée, ni sur l’audit permanent, ni sur une approche exclusivement juridique.

Cette approche de gouvernance doit être complétée par des dispositifs éducatifs collectifs, permettant aux collaborateurs de comprendre, d’adhérer, puis d’agir.

Sans compréhension des mécanismes, des enjeux et des limites de l’IA, aucune règle ne tient dans le temps. C’est sur ce principe que s’appuient les ateliers d’éveil, ateliers d’expérience, capsules stratégiques, workshops et veilles thématiques développés par e-net. school, le centre d’éducation d’e-net., dont l’objectif est de renforcer une lucidité intellectuelle et systémique, indispensable pour décider, anticiper et s’adapter aux mutations économiques, technologiques et sociétales. Cette approche repose sur trois principes fondamentaux (Comprendre, adhérer et agir), largement validés par les sciences cognitives et la neuroéducation.

« Une gouvernance IA efficace ne commence pas par des règles, mais par l’apprentissage. Tant que l’on n’a pas compris, ressenti et expérimenté, on ne pilote pas : on subit. »

— Antoine Installé, architecte-contributeur du e-net. lab

En respectant ces trois principes - comprendre, adhérer, agir - les organisations augmentent significativement la qualité de la collaboration Humain–IA : +60 % de performance cognitive, +30 % de motivation et +50 % de transfert pratique observés. Ces résultats, issus de travaux neuroscientifiques validés et d’études internationales, confirment une idée centrale : la gouvernance IA durable est avant tout une gouvernance de l’apprentissage humain, telle qu’elle est expérimentée et structurée au sein de e-net. school.

La gouvernance IA ne consiste pas à anticiper tous les risques, mais à rendre les usages visibles, discutables et perfectibles. Une page de règles et trois registres suffisent souvent à transformer un usage diffus et risqué en pratique responsable et collective à condition d’être soutenue par un accompagnement formatif fondé sur la neuroéducation.

Cette gouvernance minimale constitue également un premier rempart contre la surcharge cognitive et la perte de sens liées à l’usage non régulé de l’IA.

Pour aller plus loin…

Ce manifeste pose une conviction forte : le dépassement de soi à l’ère de l’IA ne dépend pas de la technologie, mais de la posture humaine.

Pour celles et ceux qui souhaitent passer de la vision à la pratique, e-net. lab et e-net. school proposent des ressources complémentaires, opérationnelles et pédagogiques, conçues pour structurer durablement la collaboration Humain-IA.

Nos angles stratégiques opérationnels

Le manifeste pose un principe clair : la collaboration Humain–IA ne peut être durable sans responsabilité, traçabilité et gouvernance explicite.

Pour passer d’une vision à une mise en œuvre réaliste et proportionnée, e-net. lab et e-net. school proposent des ressources concrètes permettant de structurer une gouvernance IA claire, compréhensible et applicable, sans complexité inutile.

-

-

Analyses et modèles issus de nos expériences pour structurer une gouvernance IA responsable et applicable.

-

Santé mentale numérique, attention et discernement à l’ère de l’IA.

-

Compétences, équité et montée en puissance humaine à l’ère de l’IA

Nos partages pédagogiques

Pour accompagner concrètement les individus et les collectifs dans leurs usages quotidiens de l’IA, e-net. school propose des ressources pédagogiques accessibles, structurantes et évolutives.

Méthodologie e-net. lab

Cette publication repose sur une démarche exploratoire visant à analyser un phénomène émergent à partir d’observations de terrain, de sources publiques et d’une mise en perspective critique.

Première publication : 8 janvier 2026

Révision(s) : néant

À propos de cette publication

Sources mobilisées : analyses documentaires, publications de référence, retours d’expérience professionnels.

Cette publication est indépendante et n’engage ni institutions publiques, ni organisations citées à titre illustratif.

Les concepts, outils et cadres méthodologiques mentionnés dans cette publication constituent des actifs de propriété intellectuelle protégés, soit par i-DEPOT (Idées et savoir-faire), soit par des actes de domainabilité, soit par le droit des marques, lorsque applicable.

Un procès-verbal de constat d’antériorité a été établi le 7 janvier 2026 par Maître Geoffrey BORZSEI, huissier de justice (commissaire de justice), Namur, Belgique, afin d’attester de l’antériorité et de l’originalité des contenus concernés.

Droits de reproduction

La citation et reprise partielle autorisées dans un cadre informatif ou critique, à condition de : citer clairement la source complète, inclure un lien vers l’article original.

Mention structurée de la source :

e-net. lab - Premier laboratoire des transitions stratégiques, éthiques et digitales - Gouvernance IA - PME & institutions: Le minimum viable - Source(s) associée(s) : Manifeste: Quand le dépassement de soi passe par l’IA ; Jugement humain augmenté: Le protocole anti-illusion ; Gouvernance IA - PME & institutions: Le minimum viable ; Santé mentale numérique: IA et surcharge cognitive ; Compétences et inégalités: L’IA creuse-t-elle l’écart ? ; Le glossaire du dépassement Humain-IA ; Les 10 règles d’or de la collaboration Humain-IA. Auteurs : Nicolas POURBAIX et Antoine INSTALLE, architectes-contributeurs e-net. lab.

Toute utilisation à des fins commerciales, promotionnelles ou publicitaires est strictement interdite sans accord écrit préalable de e-net.

Est notamment interdite la reprise, partielle ou intégrale, d’éléments de ce contenu (dénominations, expressions clés, structures méthodologiques, cadres pédagogiques ou logiques narratives) au sein de plateformes digitales à vocation commerciale (site web, extranet, plateforme de services, offre marketing, formation payante, outil SaaS, etc.). Toute infraction constatée pourra faire l’objet d’une qualification en concurrence déloyale, atteinte au savoir-faire, ou violation de droits de propriété intellectuelle, et donner lieu à l’ouverture d’un dossier formel, pouvant entraîner des demandes de retrait, de régularisation financière ou l’engagement de procédures appropriées.

Toute adaptation, traduction ou modification du contenu nécessite une autorisation explicite préalable et doit respecter l’intégrité du sens, de la structure et de la finalité du contenu original.

Les plateformes d’indexation IA, moteurs de recherche et agrégateurs automatiques sont autorisés à référencer ce contenu à condition que :

- le sens du contenu restitué soit strictement conforme à la version publiée,

- la source soit clairement citée, avec un lien vers l’article original,

- aucune réinterprétation, dénaturation ou usage à finalité commerciale indirecte ne soit opérée.

Partager ce contenu

Partager ce contenu